Economía y economía política de Friedman: una crítica desde el viejo keynesianismo

Thomas I. Palley*

* Consejero de Política Económica en la Federación Estadounidense del Trabajo y Congreso de Organizaciones Industriales (AFL-CIO, por sus siglas en inglés) e Investigador asociado en el Economic Policy Institute. Correo electrónico: mail@thomaspalley.com.

Manuscrito recibido en enero de 2014

Aceptado en mayo de 2014

Resumen

La influencia que Milton Friedman ha ejercido en la profesión económica es enorme. Si bien en parte su éxito se debió a las fuerzas políticas que han hecho del neoliberalismo la ideología dominante a escala mundial, también las dirigió y contribuyó a ellas. El triunfo profesional de Friedman es testimonio de las débiles bases intelectuales de la profesión económica que acepta ideas que son conceptual e intelectualmente inconsistentes. Su triunfo ha llevado a que la economía retroceda hacia el prekeynesianismo y haya expulsado de la academia al keynesianismo. El pensamiento de Friedman también enmarca la así llamada economía neokeynesiana, que simplemente es nueva macroeconomía clásica a la que se agregó la competencia imperfecta y las rigideces nominales. Al permitir la afirmación de que la macroeconomía está plenamente caracterizada por una división entre nuevo keynesianismo y nueva macroeconomía clásica, la primera cierra la pinza que excluye al viejo keynesianismo. Mientras dicha pinza no se abra, la economía permanecerá a la sombra de Friedman.

Palabras clave: Friedman, monetarismo, nueva macroeconomía clásica, nuevo keynesianismo, neoliberalismo.

Clasificación JEL: A10, B10, B30, E00.

LA INFLUENCIA DE FRIEDMAN EN LA ECONOMÍA

Milton Friedman murió el 16 de noviembre de 2006, a la edad de 94 años. Como muchos hicieron notar en ese momento, quizá fue el economista más influyente en el último cuarto del siglo xx. Si el periodo previo (1945-1975) fue la "era de Keynes", al siguiente periodo de treinta años (1975-2005) se le podría legítimamente calificar de la "era Friedman". Éste no sólo contribuyó a reformular el pensamiento en economía al desplazar la economía keynesiana, sino que tuvo una incidencia política profunda cuando estableció una relación entre capitalismo y libertad en su famosa obra publicada en 1962. Esta incidencia la atrapa Summers (2006) en su panegírico a Friedman titulado "The Great Liberator", que apareció en el New York Times poco antes de morir: "no hace mucho todos éramos keynesianos. De igual forma, cualquier demócrata honesto admitirá que ahora todos somos friedmanianos".

Ahora, en los albores de la crisis financiera mundial de 2008 y el consecuente gran estancamiento, los eventos van desfilando uno a uno ante Friedman, lo cual ha creado una esquizofrenia intelectual cuando dichos eventos hablan de lo acertado del viejo keynesianismo y, no obstante, la economía política de Friedman sigue siendo dominante entre la elite económica y política. Esa condición obstaculiza una reactivación teórica plena de la economía de Keynes, acarreando consigo graves consecuencias en la política económica.

Este ensayo presenta la crítica que desde la perspectiva del viejo keynesianismo se hace a la aportación intelectual de Milton Friedman.1 Cuestiona tanto la calidad como la perdurabilidad de los argumentos económicos de Friedman, si bien reconoce su impacto como economista político y su postura política. La etiqueta viejo keynesianismo se invoca específicamente para distinguirla del nuevo keynesianismo, ya que esta última se ha corrompido y ha confundido el significado del keynesianismo, dificultando más la distinción entre economía keynesiana y macroeconomía de Friedman, que ahora da forma a la macroeconomía moderna.

La economía neokeynesiana es una mutante genérica del así denominado "keynesianismo bastardo" IS-LM asociado con Paul Samuelson de la Escuela de Economía del Massachusetts Institute of Technology (MIT).2 El nuevo keynesianismo abandona el vestigio keynesiano y deja atrás el umbral intelectual, de manera que las expectativas racionales devienen la nueva macroeconomía a la que se agrega la competencia imperfecta y las rigideces del precio y salario nominal. En consecuencia, sería mejor etiquetarla como "nueva economía pigoviana" (Palley, 2009), que por el énfasis que pone en las imperfecciones del mercado representa el enfoque de Arthur Pigou, quien fuera el gran rival intelectual de Keynes en Cambridge en los años de 1930. Esto quiere decir que el nuevo keynesianismo tiene poco que ver con Keynes y mucho con Friedman, padre intelectual de la nueva macroeconomía clásica.

Este vínculo estrecho entre Friedman y el nuevo keynesianismo pasa en gran medida desapercibido y esa falta de reconocimiento coloca una barrera casi infranqueable para entender y reabrir la macroeconomía. Al afirmar que la macroeconomía se caracteriza por una división entre nuevo keynesianismo y nueva macroeconomía clásica, aquél cierra la pinza que excluye al viejo keynesianismo.3 Mientras dicha pinza se mantenga cerrada, la economía permanecerá a la sombra de Friedman, y liberarse de ese atenazamiento requiere reacondicionar el papel que desempeña el pensamiento de Friedman en la economía neokeynesiana y hacer clara la distinción entre la economía del viejo keynesianismo y la economía del nuevo keynesianismo.

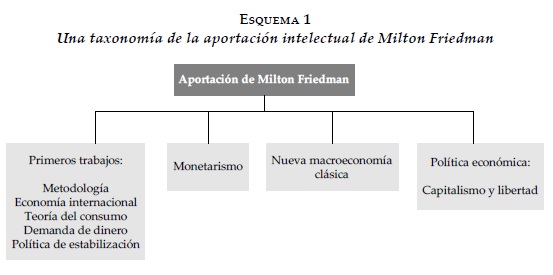

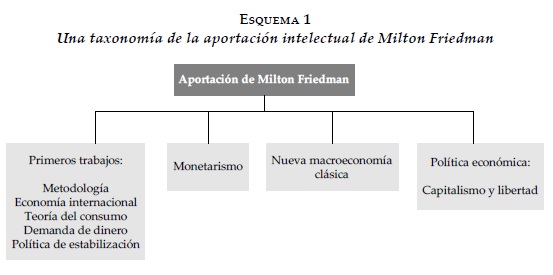

UNA TAXONOMÍA DE LA APORTACIÓN DE MILTON FRIEDMAN

El esquema 1 proporciona una taxonomía de la aportación de Friedman, que hemos dividido en cuatro partes y que nos es útil para estructurar lo que resta de este ensayo. Al primer aspecto lo denominamos "primeros trabajos" de Friedman e incluye sus aportaciones a la metodología, la economía internacional, la teoría del consumo, la teoría de la demanda de dinero y la política de estabilización. El segundo aspecto lo denominamos "monetarismo"; al tercero, "nueva macroeconomía clásica", que asociamos con la doctrina de la tasa natural de desempleo a la que también se hace referencia como tasa de desempleo no aceleradora de la inflación (NAIRU, por sus siglas en inglés). Tobin (1980; 1981) hace referencia al monetarismo original como monetarismo marca I y a la nueva macroeconomía clásica como monetarismo marca II. El cuarto aspecto lo denominamos "política económica" y hace referencia al trabajo de Friedman referente a la relación entre capitalismo y libertad.

PRIMEROS TRABAJOS

Aun cuando los primeros trabajos constituyen un cuerpo ecléctico, su impacto ha sido fuerte y establece las bases para sus aportaciones posteriores y hay una consistencia significativa entre ambas partes.

Metodología

Siendo que ante todo es un macroeconomista monetarista, Friedman tuvo un impacto importante en la comprensión que los economistas tienen de la metodología. Su ensayo "The Methodology of Positive Economics" (Friedman, 1953a) ha tenido una influencia profunda, prolongada y maléfica en la comprensión que los economistas tienen de la economía. En efecto, una generación de estudiantes abrevó en esa fuente e impacto a prácticamente la mayoría de ellos (los viejos keynesianos incluidos). Dejando a la profesión prácticamente vacía de cualquier preocupación metodológica, sigue dominando en la comprensión económica y su práctica, a pesar de sus profundas deficiencias.

El marco metodológico de Friedman descansa en una distinción entre economía "positiva" y economía "normativa". El núcleo de la premisa es: "La economía positiva es, en principio, independiente de cualquier postura ética o juicio de valor [...] lidia con lo 'que es' y no con lo 'que debería ser' (Friedman, 1953a: 4) (Traducción del texto original en inglés).

Según Friedman, la economía positiva tiene que ver con teoría económica, mientras que la normativa tiene que ver con la economía política y con lo que deberían ser las metas de la economía. De acuerdo con esa afirmación, la teoría es a-valorativa y los valores del teórico no la afectan, como tampoco los valores de la sociedad en la cual trabaja el teórico. Esto es ampliamente sostenido y sirve para aislar a la economía dominante de cualquier acusación que la señale como una economía sesgada. Además, en la medida que no hay un discurso activo en torno a la metodología o que se interese en ella, estorba cualquier argumentación que se coloque sobre la mesa contra una teoría sesgada. En esta tendencia, se enseña a los estudiantes que la teoría económica ortodoxa está exenta de valoraciones.

Una segunda falacia metodológica fue la afirmación de Friedman respecto a la no pertinencia de la realidad de los supuestos para la teoría económica: "La pregunta pertinente que hay que formular sobre los 'supuestos' de una teoría no es si son descriptivamente 'realistas', porque nunca lo son, sino si son aproximaciones suficientemente pegajosas para los propósitos en cuestión. Y esta pregunta sólo se la puede responder viendo si la teoría sirve (Friedman, 1953a: 15) (Traducción del texto original en inglés).

Según Friedman, una teoría no puede ser juzgada por el realismo (o carencia del mismo) de sus supuestos, dejando que éstos sean un parámetro libre a ser construido y seleccionado de forma tal que la teoría funcione.

Al formular el argumento, Friedman, el polémico, apela a la ciencia natural para luego hacer un truco de prestidigitación que transfiere el argumento a la economía. Y, sin embargo, la economía es una ciencia social y del comportamiento que la marca como algo fundamentalmente diferente. Los átomos no hacen teoría de los átomos, no obstante, los actores económicos (los economistas) hacen teoría en relación con otros actores económicos. Los economistas son teóricos y actores por igual en la economía. Tienen capacidad introspectiva y sus propias experiencias económicas, aportando una base adicional para evaluar una teoría que no está ahí disponible en las ciencias naturales. Esas ideas introspectivas y experiencias son información que imponen límites adicionales a la teoría económica que deben reconciliarse con la teoría. Pero Friedman ignora campalmente ese hecho.4

Juntas, la negación de los valores en la teoría y la negación del realismo de los supuestos, levantan una barrera contra la crítica. La negación de valores en la teoría protege a la moderna macroeconomía en contra de los cargos de que está altamente politizada; mientras que la negación del realismo de los supuestos protege a la teoría macroeconómica, incluyendo los microfundamentos de la macroeconomía.

Los viejos keynesianos son culpables por aceptar el deficiente análisis metodológico de Friedman y, sin embargo, son quienes se han venido a convertir en las víctimas de ese análisis debido a que protege contra la crítica a la teoría microeconómica y a la macroeconomía ortodoxas (incluida la crítica keynesiana) que podría impulsar el cambio.

Economía internacional

Con relación a la economía internacional, el ensayo de Friedman (1953b) en defensa de los tipos de cambio flexible ("The Case for Flexible Exchange Rates") ha tenido una importancia enorme. Posterior a la gran depresión, los tipos de cambio flexibles fueron vistos con suspicacia política a causa de las devaluaciones competitivas de los años de 1930. Friedman fue pionero en la rehabilitación de los tipos de cambio flexibles, argumentando que facilitaban el ajuste económico internacional, evitando la necesidad de dolorosos y disruptivos ajustes en el nivel de los precios internos, y evitando la posible inquietud e inestabilidad asociada con la devaluación oficial discrecional.

Friedman argumenta que los tipos de cambio flexibles son preferibles dado que constituyen un mecanismo de mercado autoajustable y no uno que descanse en intervenciones gubernamentales, que es muy probable se ejerzan con muchas deficiencias y que sean potencialmente desestabilizadoras. En contraste, se parte del supuesto de que el mercado se estabiliza. El argumento es que existe un tipo de cambio de equilibrio fundamental. Cuando el tipo de cambio se devalúa, los especuladores compran y obtienen ganancias en la medida que hacen que la tasa suba hasta alcanzar un equilibrio fundamental: cuando se sobrevalua, los especuladores venden y se enriquecen conforme hacen descender la tasa hacia el equilibrio fundamental.

Los dos argumentos, respecto al papel que desempeña la estabilización de los mercados y los efectos disruptivos de las intervenciones de política pública discrecionales, aparecen reiteradamente en el análisis macroeconómico monetario de Friedman. Desde la posición ventajosa de un viejo keynesiano, hay tres críticas que se pueden hacer a la validez de los argumentos referentes a los tipos de cambio.

Primera, Friedman afirma la estabilidad de los mercados de los tipos de cambio (FX). Pero, la evidencia empírica muestra que éstos nunca están en paridad con el poder adquisitivo (PPA) y que, por el contrario, parecen seguir largos vaivenes que se extienden por encima y por debajo del PPA. Además, los modelos empíricos son terriblemente malos para predecir el tipo de cambio real (Meese y Rogoff, 1983; Taylor, 1995; Rogoff, 1999; Isard, 2007; Chinn, 2008). Estas características del tipo de cambio llevaron a Tobin (1978) a proponer un pequeño impuesto a las transacciones con FX para desalentar a los especuladores y reducir la volatilidad de los tipos de cambio. Este escepticismo del viejo keynesianismo hacia el papel que desempeña la estabilización de la especulación en los mercados de FX se extiende hacia los mercados financieros de forma más amplia. En la Teoría General, Keynes (1936) cuestiona la capacidad de los mercados financieros para establecer tasas de interés apropiadas debido a fluctuaciones en la preferencia de liquidez. Minsky (1992) formuló su hipótesis de estabilidad financiera, según la cual los mercados financieros tienen una predisposición genética a crear gradualmente condiciones inestables (Palley, 2011).

Segunda, la economía política de Friedman se construye en términos de un mercado competente con un conjunto unificado de intereses vs un gobierno incompetente. Los viejos keynesianos cuestionan ambos supuestos, el de la competencia de los mercados y el de la incompetencia de los gobiernos. Además, los keynesianos de izquierda critican el supuesto de los intereses del mercado unificado. En realidad, las economías están marcadas por la clase y otras divisiones económicas. En un mundo de tipos de cambio flexibles, el capital financiero puede disciplinar a los gobiernos amenazando con salir si se empeñan en seguir políticas no favorables a dicho capital. Este problema se agudiza, particularmente, en las economías de mercado emergentes, si bien también aflige a las economías desarrolladas. Por ejemplo, el presidente Francois Mitterand abandonó su programa keynesiano de estímulos en junio de 1993, que marcó el desplazamiento europeo hacia el neoliberalismo, y ese abandono se le puede atribuir en parte a las presiones del mercado financiero internacional que se ejercieron en contra del marco francés. Ese tipo de conflictos se encuentra totalmente ausentes de la economía política de Friedman.

Tercera, desde la perspectiva de Friedman, y respecto a los efectos económicos reales que tiene la flexibilidad de los tipos de cambio, supone que tienen resultados benignos. No obstante, los estructuralistas latinoamericanos (Sunkel, 1958; Olivera, 1964) argumentan que la depreciación del tipo de cambio puede acarrear una inflación disruptiva a consecuencias de las restricciones estructurales y desequilibrios en las economías en desarrollo. La depreciación en el tipo de cambio también puede ser contradictoria (Krugman y Taylor, 1978).

La teoría del consumo

La famosa monografía de Friedman (1957) A Theory of the Consumption Function constituye su aportación a la teoría del consumo. Los viejos keynesianos la aceptaron en gran medida e hicieron aportaciones afirmativas importantes. Sin embargo, también contenía implicaciones importantes subversivas para el keynesianismo y de las cuales da la impresión que los viejos keynesianos no estuvieron conscientes.

La Teoría General de Keynes introduce en la macroeconomía la noción de una función de consumo agregado. Con base en su afirmación de una ley psicológica general, Keynes (1936: 96) afirma que la propensión marginal al consumo (PMC) se reduce con el ingreso, lo que implica una disminución de la propensión promedio de consumo (PPC); esta afirmación la cuestionó Kuznets (1946), que mostró que la economía estadounidense se caracterizaba por una PPC constante de largo plazo. El hallazgo de Kuznets marcó una aparente contradicción mediante la cual datos de corto plazo mostraron una PPC decreciente, en comparación con datos de largo plazo que mostraron una PPC constante.

La hipótesis del ingreso permanente (HIP) que formulara Friedman reconcilió esta aparente contradicción y también hizo aportaciones teóricas importantes. La hipótesis afirma que los hogares consumen una proporción fija del ingreso permanente, definido como valor anual de las corrientes de ingreso y riqueza que se espera tener a lo largo de la vida. Respecto a la teoría, la HIP hace hincapié en la naturaleza de visión futura que caracteriza a las decisiones de consumo, que toman en consideración tanto ingresos presentes como futuros. Esa dimensión de visión futura había quedado entendida en la formulación de Keynes, que tendía a destacar el papel que desempeña el ingreso presente.

Segundo, la HIP explicó por qué el gasto en consumo tendería a ser muy estable y fluctuaría menos en comparación con el ingreso presente. Eso se debía a que el ingreso permanente, que se calculó a lo largo de la vida, es mucho más estable en comparación con el ingreso presente que fluctúa con el ciclo económico. De forma que, el consumo sólo cambia en respuesta a cambios en el ingreso permanente, y las fluctuaciones temporales en el ingreso presente no tienen un impacto, excepto si llegan a una fracción tal que afectan al ingreso permanente.

Tercero, la HIP explica la persistencia del gasto en consumo, proporcionando una alternativa a las normas y hábitos de consumo como explicación de la persistencia. De acuerdo con la HIP, la persistencia del consumo se deriva de la estabilidad del ingreso permanente que fluctúa muy poco a causa de su alcance, esto es, que se extiende a lo largo del ciclo de vida. Este contraste con normas y hábitos que explican la persistencia en términos de altos costos de utilidad resultado del ajuste al consumo.

Cuarto, la HIP resultó consistente con la teoría de consumo de máxima utilidad a lo largo del ciclo de vida, que desarrollaron Modigliani y Brumberg (1954), la cual implica el supuesto especial de una tasa de interés cero, una tasa de descuento cero, sin restricciones de liquidez y mercados financieros perfectos completos que permiten la monetización de corrientes de ingreso futuro en el ingreso permanente.

Referente a la aportación empírica, Friedman reconcilio la diferencia entre regresiones (de sección cruzada) de estimaciones de consumo de corto plazo y regresiones de series de tiempo de estimaciones de consumo agregado de largo plazo apelando a un argumento de errores estadísticos en las variables. El argumento es que las estimaciones de sección cruzada usan el ingreso real de los hogares más que el ingreso permanente de los hogares. Dado que la mayor parte de los hogares se ubica en la parte media de la distribución de los ingresos, la distribución observada del ingreso real de los hogares (que es igual al ingreso permanente más sacudidas transitorias) tiende a estar más extendida en comparación con el ingreso permanente. En consecuencia, las regresiones que hacen estimaciones usando el ingreso real tienden a encontrar una pendiente plana: así, encuentran que las estimaciones de función de consumo de sección cruzada son más planas respecto a las estimaciones de series de tiempo de la función de consumo per cápita agregado.

Hay dos aspectos subversivos de la HIP de Friedman que básicamente pasó por alto el viejo keynesianismo. Primero, la HIP afirma que todos los hogares tienen la misma PMC constante de su ingreso permanente. En consecuencia, la redistribución del ingreso no impacta al gasto en consumo agregado y la desigualdad del ingreso deja de ser pertinente para el gasto en consumo y la demanda agregada (DA), lo cual resulta inconsistente con el pensamiento keynesiano basado en la función de consumo de Keynes, donde la desigualdad del ingreso reduce el gasto en consumo y la DA porque la PPC decrece con el ingreso. Por ende, al aceptar la HIP los viejos keynesianos neutralizaron un elemento importante de la agenda de la política económica keynesiana.

Segundo, la función de consumo keynesiana era de estancamiento, es decir, implicaba tendencias de estancamiento que se autoafirmarían conforme la economía creciera y el ingreso se incrementara a consecuencia de una declinación de PPC. Este argumento estaba asociado con la postura del keynesianismo de izquierda articulada por Steindl (1952). La HIP debilitó tal argumento.

Ello apunta hacia una distinción entre el viejo keynesianismo y los keynesianos de izquierda. Los viejos keynesianos creen que la distribución del ingreso es importante para la DA y que la economía puede quedar atrapada por el desempleo debido a una DA escasa atribuible a la desigualdad del ingreso. Los keynesianos de izquierda agregan la hipótesis del estancamiento secular. La HIP debilita ambas posturas. No obstante, el argumento del viejo keynesianismo puede restaurarse vía una teoría del consumo con ingreso relativamente permanente (Palley, 2010) que amalgama los argumentos de Keynes (1936), Duesenberry (1948 [1971]; 1949) y Friedman (1957). De acuerdo con la HIP relativa, la PPC de los hogares es una función negativa del ingreso relativamente permanente de los hogares. En consecuencia, la creciente desigualdad del ingreso puede reducir la PPC en toda la economía. De esta forma, las ideas perspicaces con que Friedman formuló su teoría del consumo se tornan consistentes con la teoría del viejo keynesianismo y la relación que observa entre desigualdad del ingreso y DA.

Demanda de dinero

Otro elemento importante de los primeros trabajos de Friedman fue su ensayo "The Quantity Theory of Money: A restatement" (1956 [1969]), cuyos contenidos constituyen los elementos teóricos de la doctrina que vendrían a ser conocidos como "monetarismo". Este ensayo de Friedman aporta una declaración sistemática de la macroeconomía monetarista de la escuela de Chicago, que desarrollaron en los años de 1930 Henry Simons y Lloyd Mints. De acuerdo con Friedman, la versión de la teoría cuantitativa de la escuela de Chicago era una teoría de la demanda de dinero: "La teoría cuantitativa es, en primer lugar, una teoría de la demanda de dinero" (Friedman, 1956 [1969: 95]) [Traducción del texto original en inglés].

La formulación que Friedman hace respecto a la demanda de dinero ocasiona que surjan cuatro aspectos importantes. Primero, la demanda de dinero no es una porción fija del ingreso como sostiene la ecuación de Cambridge de la balanza de efectivo; por el contrario, es una función de todas las variables pertinentes incluyendo preferencias, tecnologías de transacción, tasas de rendimientos en todos los activos (incluso bienes durables), inflación, riqueza e ingreso nominal. También es homogénea en grado con relación a los precios (Friedman, 1956 [1969]: 100-2]). Segundo, la demanda de dinero es una solución resultado de un programa de selección de maximización de rendimientos definido en magnitudes reales (Friedman, 1956 [1969]: 102]). Tercero, la demanda de dinero es una transformación funcional de la velocidad del dinero y viceversa, de forma que la velocidad del dinero queda determinada por la razón de ingreso nominal respecto a la demanda de dinero (Friedman, 1956 [1969, p. 103]). Y cuarto, la función demanda de dinero es estable. Ello no significa que sea constante: no significa que no esté sujeta a frecuentes y grandes cambios impredecibles:

El teórico cuántico acepta la hipótesis empírica según la cual la demanda de dinero es altamente estable —más estable que funciones como la función de consumo [...] el teórico cuántico no quiere decir, y en general no lo hace, que la cantidad real de demanda de dinero por unidad de producto o la velocidad de circulación del dinero sea numéricamente constante a lo largo del tiempo; [...] Ya que espera que la estabilidad se encuentre en la relación funcional entre demanda de cantidad de dinero y las variables que la determinan[...] (Friedman, 1956 [1969: 108-9]) [Traducción del texto original en inglés).

Desde el punto de vista del viejo keynesianismo, la reformulación que hace Friedman (1956 [1969]) de la teoría de la cantidad de dinero es plenamente aceptable, sólo se vuelve problemática cuando posteriormente se la coloca en el contexto del monetarismo. De hecho, la formulación que hace Friedman de la demanda de dinero como parte de un programa general de maximización de rendimientos corrige una especificación de flujo muy importante en el modelo keynesiano IS-LM (Hicks, 1937). La especificación IS-LM inicial trata las decisiones que toman los hogares respecto al ahorro (relativas a LM) como separadas del portafolio de decisiones (relativas a LM). Dicha separación contribuye a un falso debate que representa a la teoría de preferencia de liquidez keynesiana como una teoría basada en el stock de las tasas de interés y a la teoría clásica de fondos prestables como una teoría de tasas de interés basada en el flujo (Smith, 1958; Tsiang, 1956; Patinkin, 1958). Sin embargo, una vez que la demanda de dinero es vista como parte de un problema de elección unificada en el cual los agentes obtienen el máximo de rentabilidad al ahorrar y al mismo tiempo tomar decisiones sobre la asignación de cartera, la distinción es debatible. Las preferencias de liquidez es por igual una teoría de stock como de flujo debido a que las variables que afectan las decisiones de ahorrar también afectan a las decisiones de cartera y viceversa. Las decisiones que tienen que ver con el flujo de ahorro y las que tienen que ver con el stock se toman al mismo tiempo como parte de un proceso de toma de decisiones unificado e interdependiente. La forma como Friedman enmarca la demanda de dinero refuerza, por ende, la teoría keynesiana de tasas de interés basada en preferencia de liquidez que quedó incorporada en la formulación que hace Tobin (1982) del modelo IS-LM keynesiano de múltiples activos.5

Irónicamente, el aspecto de la reformulación que hace Friedman (1956 [1969]) de la teoría de la cantidad —que a la postre pasará a ser controvertida— tiene que ver con la estabilidad de la demanda de dinero, que es una aseveración que los viejos econométricos keynesianos que trabajaban con la demanda de dinero aceptaban ampliamente en los años de 1960. No obstante, la estabilidad de la demanda de dinero y la velocidad del dinero vinieron a convertirse en un tema al quedar insertos en el monetarismo. Esto se debe a que el monetarismo sostiene que la estabilidad de la velocidad prueba que las fluctuaciones económicas no son el resultado de acciones del sector privado sino, por el contrario, resultado de cambios inducidos que el banco central aplicaba en la oferta de dinero.

Políticas de estabilización

El último elemento que conforma los primeros trabajos de Friedman tiene que ver con los escritos donde aborda las políticas de estabilización, tanto fiscales como monetarias. Un artículo muy importante que aborda este aspecto fue el de "A Monetary and Fiscal Framework for Economic Stability" (Friedman, 1948), y un segundo fue el de "The Lag in Effects of Monetary Policy" (Friedman, 1961). El trabajo de 1948 es totalmente keynesiano en cuanto que identifica la necesidad de estabilizar la DA para reducir el desempleo y las fluctuaciones cíclicas. Una lectura desde la perspectiva del viejo keynesianismo en 1948 probablemente habría encontrado poco con lo cual no estaría de acuerdo. Sin embargo, en el artículo había argumentos que posteriormente se utilizarían no sólo en contra de los viejos keynesianos, sino que se pondrían al servicio de la política macroeconómica neoliberal.

El trabajo de Friedman referente a la política de estabilización se enfocó en dos temas: rezago en la aplicación de políticas y las incertidumbres creadas por políticas discrecionales. En su trabajo de 1948 Friedman escribe:

Hay una fuerte presunción que estas acciones discrecionales en general quedarán sujetas a largos rezagos en comparación con las reacciones automáticas y, por ende, serán desestabilizadoras incluso con mayor frecuencia [...]. Las bases de esta presuposición puede verse mejor si subdividimos en tres partes el rezago total en cualquier acción que busque compensar una alteración: 1) el rezago entre la necesidad de una acción y el que se reconozca dicha necesidad; 2) el rezago entre el reconocimiento de la acción necesaria y realizar la acción, y 3) el rezago entre la acción y sus efectos (Friedman, 1948 [1971: 344]) [Traducción del texto original en inglés).

Los diversos rezagos asociados con la política discrecional hablan de la superioridad de los estabilizadores automáticos, cuando son posibles. Esto es algo con lo cual un keynesiano de viejo cuño también concordaría, empero, en trabajos subsecuentes donde aborda el monetarismo, la crítica de Friedman a la política macroeconómica se fue politizando crecientemente, reflejando su economía política y su antipatía hacia el gobierno. Así, en lugar de que el problema fueran los rezagos técnicos, la incompetencia del gobierno y su sesgo se convirtieron en el problema; como lo evidencia la afirmación que hace Friedman en el sentido de que la política monetaria discrecional fue la principal causa de la gran depresión. Dado ese razonamiento, las reglas para guiar las políticas pasaron a ser un medio importante para reducir la incertidumbre inducida por las políticas y con ello evitar sobredimensionar cualquier beneficio de la discrecionalidad. Esta crítica política de la política discrecional quedó silenciada en su artículo de 1948, si bien ya estaba presente:

En conclusión, me gustaría enfatizar el objetivo modesto de la propuesta [...]. Lo que reclama demos seria consideración es que proporciona un marco estable para medidas fiscales y monetarias que eliminan en gran medida la incertidumbre e implicaciones políticamente indeseables de las medidas discrecionales tomadas por las autoridades gubernamentales [...] (Friedman, 1948 [1971: 351]) (Traducción del texto original en inglés).

Una característica final del trabajo de Friedman de 1948 es que identifica y hace hincapié en la rigidez del precio y los salarios como causa del desempleo. Desde el punto de vista de la economía teórica, dicho hincapié habla de la firme creencia de Friedman en las rigideces como la causa del desempleo; desde la óptica de la economía política habla de su creencia en la estabilidad y lo óptimo que resultan las economías de mercado con precios flexibles, y, desde la perspectiva política, habla de su creencia en la necesidad de flexibilizar los precios y los salarios nominales. Estas características del pensamiento de Friedman se reafirmarían cuarenta años después en su teoría de la tasa natural de desempleo (Friedman, 1968).

MONETARISMO

El monetarismo representa una consolidación de los primeros trabajos de Milton Friedman en el ámbito de la macroeconomía monetaria. También lo lanzaron a la palestra mundial como un teórico de la macroeconomía.

La causa empírica a favor del monetarismo la asentó Friedman en la historia monetaria de Estados Unidos de la que fue coautor (Friedman y Schwartz, 1963a; 1963b); la causa teórica a favor del monetarismo la estableció en su reformulación de 1956 de la teoría cuantitativa y en su monografía de 1971 "A Theoretical Framework for Monetary Analysis", mientras que el análisis de la política monetarista, incluida la crítica a la política keynesiana, la dejó asentada en un documento del Institute of Economic Affairs titulado "The Counter-Revolution in Monetary Theory" (Friedman, 1970).

El monetarismo empírico (Friedman y Schwartz, 1963a; 1963b) buscó aportar evidencia histórica que apoyara las aseveraciones teóricas del monetarismo, entre las cuales debe incluirse una relación estrecha y estable entre oferta de dinero e ingreso nominal y la afirmación de que el crecimiento en la oferta de dinero ocasiona crecimiento en el ingreso nominal. Asimismo, afirmó que la Reserva Federal (Fed) era en gran medida responsable de la severidad de la gran depresión debido a que de forma errada amarró la política monetaria en el momento mismo del inicio de la depresión:

Cuando se examina la evidencia en detalle resultó que había que culpar en gran medida a una política económica equivocada. En el periodo de 1929 a 1933, en Estados Unidos hubo una reducción de un tercio en la cantidad de dinero. Es claro que esa reducción provocó que la depresión se alargara por más tiempo y la hizo más severa de lo que tendría que haber sido. Además, e igualmente importante, resultó que dicha reducción no fue consecuencia de que los caballos se negaran a abrevar. No fue consecuencia de una incapacidad para tirar de las riendas. Fue consecuencia directa de las políticas que siguió el sistema de la Reserva Federal (Friedman, 1970: 6) [Traducción del texto original en inglés].

Este argumento empírico se utilizó a su vez para respaldar la recomendación monetarista que dirigió la política monetaria.

El monetarismo teórico (Friedman, 1956; 1971) se lo puede comprender mejor por medio de la ecuación de Fisher:

MV = Y = Py [1]

donde M es la oferta de dinero nominal; V, la velocidad del dinero; Y, el producto interno bruto (PIB) nominal; P, el nivel de precios; y, el PIB real. Esta relación se la puede transformar a una de tasas de cambio dada por:

gM+ gV= gY= gP+ gy [2]

donde gM es la tasa de crecimiento de oferta de dinero nominal; gV, la tasa de velocidad del cambio; gY, la tasa de crecimiento de PIB nominal; gP, la tasa de inflación, y gy, la tasa de crecimiento del PIB real.

De acuerdo con la teoría monetaria, la oferta de dinero y el crecimiento en la oferta de dinero son aspectos que controla el banco central. La demanda de dinero y la velocidad son estables, como lo sostuvo Friedman (1956 [1969]) en su reformulación de la teoría de la cantidad, implicando que gv = 0. Finalmente, la relación de causalidad va de MV a Py como supuestamente los documentaron Friedman y Schwartz (1963a; 1963b). Entonces, al ensamblar las piezas se entiende que la autoridad monetaria controla el crecimiento del ingreso nominal. Si el crecimiento del PIB real está determinado exógenamente de acuerdo con la teoría neoclásica del crecimiento y es igual a un porcentaje k, entonces la autoridad monetaria puede conseguir estabilidad de precios mediante crecimiento estable del producto real estableciendo un crecimiento de oferta de dinero nominal igual a un porcentaje k por año.

Este marco monetarista consolida la mayor parte de los temas en los primeros trabajos de Friedman en macroeconomía monetaria. La economía de mercado privado es estable debido a la estabilidad de la velocidad y la demanda de dinero. Dejando de lado los trastornos aleatorios, las fluctuaciones en la actividad económica se deben a fluctuaciones en el crecimiento de la oferta de dinero ocasionada por la política monetaria, lo cual hace que las políticas incompetentes de los gobiernos sean las responsables de las fluctuaciones económicas. A nivel de las políticas, ello augura el reemplazo de políticas monetarias discrecionales por políticas basadas en reglas. Desde una perspectiva monetarista, la regla debe ser un crecimiento estable de porcentaje k de oferta de dinero.6

Una tercera característica del modelo monetarista es que la política fiscal no es ineficaz: "Los keynesianos hacían referencia, como una clara implicación de su postura, a la proposición de que la política fiscal por sí misma es importante en cuanto afecta el nivel de ingreso [...] Los monetaristas rechazaron esa proposición y sostuvieron que la política fiscal por sí misma es en gran medida ineficaz, y que lo que importa es lo que sucede a la cantidad de dinero (Friedman, 1970: 8) [Traducción del texto original en inglés]. La lógica de esta aseveración se sigue de la ecuación de Fisher más la afirmación de que MV es causa de Y.

Una cuarta característica del monetarismo, que también ya se deja ver en los trabajos de Friedman sobre economía política, es la polémica inteligente de Friedman. Esto lo ejemplifica la afirmación que hace en cuanto a que "la inflación siempre y en todo lugar es un fenómeno monetario" (Friedman, 1970: 11), que si bien se ha convertido en un aforismo del monetarismo, ningún viejo keynesiano habría estado en desacuerdo con ese planteamiento. La inflación tiene que ver con la tasa de cambio de los precios nominales y esto es intrínsecamente un fenómeno monetario, sin embargo, la pregunta de fondo es ¿qué ocasiona la inflación? Para los monetaristas, la inflación la ocasiona el banco central que maneja el crecimiento de la oferta de dinero por encima del crecimiento del producto real. Los viejos keynesianos sostienen que la inflación también puede tener su causa en la economía del sector privado. Los mercados financieros pueden endógenamente alimentar el crecimiento excesivo de demanda nominal y los mercados laborales pueden disparar la inflación de costos vía el conflicto sobre la distribución del ingreso. Los economistas estructuralistas latinoamericanos (Sunkel, 1958; Olivera, 1964) también hicieron hincapié en inflación importada que surge de las condiciones de subdesarrollo económico.

Más que simplemente rechazar la teoría monetarista de la inflación, el viejo keynesianismo rechaza el monetarismo tanto en su aspecto empírico como teórico. En lo que se refiere al aspecto empírico, Tobin (1970) hizo la crítica y mostró que el patrón de oferta de dinero —correlaciones de ingreso nominal que Friedman y Schwartz (1963a; 1963b) afirmaron conformaban el monetarismo— era, de hecho, consistente con un modelo ultrakeynesiano, donde el déficit presupuestario era contracíclico y monetariamente financiado. Temin (1976) hizo otra crítica al monetarismo empírico en la que concluye que la hipótesis del shock del gasto keynesiano para explicar la gran depresión expone en mejores términos lo oportuno de y el patrón de tasas de interés y de ajustes de ingreso en comparación con la hipótesis del shock de la oferta de dinero monetarista.

La crítica de Friedman a la política monetaria que sostuvo la Reserva Federal en el periodo 1929-1930 es fácilmente equiparable con la crítica hecha por el viejo keynesianismo a la Fed, por actuar de manera inferior al óptimo. No hay duda que la Reserva Federal pudo haber hecho más, especialmente a la luz de las lecciones de la revolución keynesiana en macroeconomía. No obstante, ello no equivale a decir que fue la causa de la depresión. Además, habla de la necesidad de políticas discrecionales más que políticas basadas en reglas. La crisis financiera de 2008 confirmó ampliamente lo innovadora que puede ser la Reserva Federal y su disposición para formular políticas que a la postre contribuyeron a controlar la crisis.

En relación con el monetarismo teórico, Tobin (1974) criticó a Friedman por el uso que hizo de un modelo IS-LM. En un modelo así, la única forma de derivar proposiciones monetaristas respecto a la ineficacia del dinero dirigiendo al ingreso nominal y las políticas fiscales es suponer una curva lm vertical, en la cual la demanda de dinero es estrictamente proporcional al ingreso. Dado que dicha hipótesis es rechazada explícitamente, ello mostró la incoherencia teórica del monetarismo.7

Otra crítica teórica completamente distinta es la de los poskeynesianos (Kaldor, 1970; 1982; Moore, 1988; Palley, 2013) que objetaron la teoría monetarista de la oferta de dinero. La piedra angular del monetarismo es que los bancos centrales controlan la oferta de dinero, dejando, en consecuencia, que el control de ésta sea fuertemente exógeno. Los poskeynesianos buscaron demoler esa piedra angular y afirmaron que la oferta de dinero está determinada endógenamente por los empréstitos bancarios. Esta crítica no sólo deshace las recetas de política monetaria que se enfocan en el crecimiento de la demanda de dinero, sino que devalúa la explicación monetarista de las fluctuaciones económicas, la misma que culpa a los bancos centrales por, supuestamente, administrar con deficiencia la oferta de dinero. Finalmente, también cuestiona la afirmación monetarista según la cual la Reserva Federal fue la causante de la gran depresión al permitir que la oferta de dinero se contrajera catastróficamente.

En lo que concierne a la política monetarista, al usar un modelo IS-LM estocástico, Poole (1970) mostró que dirigirse a la oferta de dinero resulta óptimo cuando los shocks dominan en IS (sacudidas en el sector real). La lógica es que dirigirse a las tasas de interés aísla la economía real de turbulencia que se origina en el sector financiero.

El análisis de Poole (1970) generó la pregunta empírica respecto a la estabilidad de LM y la demanda de dinero. Para los monetaristas, los desarrollos históricos produjeron otro estallido debido a que los años de 1970 dieron con el periodo de "pérdida de dinero", cuando las ecuaciones convencionales de demanda de dinero sistemáticamente predijeron excesivamente balanzas de dinero real y posterior a ello las ecuaciones de demanda de dinero probaron ser reiteradamente inestables (Goldfeld y Sichel, 1990).

La gota que derramó el descredito del monetarismo fue su error en la acción. Como lo documentara Tobin (1981), al inicio de los años de 1970 los banqueros centrales abrazaron crecientemente el monetarismo y para el mes de octubre de 1979 la Reserva Federal formalmente adoptó metas cuantitativas para las reservas bancarias. Sin embargo, esa década se caracterizó por un promedio de inflación alta al igual que de desempleo, acompañado por gran volatilidad del crecimiento de la oferta de dinero. Después de ese mes de octubre de 1979, la Reserva federal experimentó con metas de reserva cuantitativas que produjeron significativa volatilidad de las tasas de interés que contribuyeron a complicaciones con el tipo de cambio. Estas dificultades llevaron al abandono de procedimientos de operación monetarista en 1981. Todo este episodio se acerca más a un mero experimento, hasta donde es razonablemente posible en el mundo político de la economía política y como el propio monetarismo se encontró deseando que se lo viera, tal y como había predicho el viejo keynesianismo.

NUEVA MACROECONOMÍA CLÁSICA

Ahora el monetarismo es una curiosidad histórica, teórica y empíricamente desacreditado, y, no obstante, el macroeconomista Milton Friedman no lo está. La razón es la reinvención que Friedman (1968) hizo del monetarismo como nueva macroeconomía clásica (NMC), a la que Tobin (1981) hace referencia como monetarismo marca II. La nueva teoría se enfocó en la curva de Phillips e introdujo la idea de una tasa natural de desempleo, también conocida como la NAIRU. Explica la curva de Phillips en términos de una percepción errónea que la teoría monetaria tiene del ciclo económico. La interpretación errónea de la inflación tiene como resultado que la economía genere una relación empírica que semeja la curva de Phillips del antiguo keynesianismo. Empero, de aclararse tales interpretaciones erróneas, la economía vuelve a la tasa natural de desempleo que no resulta afectada por la inflación.

La teoría de Friedman (1968) de percepción errónea de la inflación operó como contrapropuesta a la curva de Phillips de la teoría del viejo keynesianismo que afirmaba la existencia de un trade-off en el largo plazo entre inflación y desempleo. Esa afirmación keynesiana cuestionó una creencia esencial para el monetarismo respecto a la neutralidad del dinero en el largo plazo. De acuerdo con la teoría de Friedman, la tasa natural de desempleo o NAIRU refleja fricciones reales e imperfecciones en los mercados laborales:

Para evitar malos entendidos, permítaseme enfatizar que al hacer uso del término tasa "natural" de desempleo no quiero sugerir que sea inmutable o que no cambie. Por el contrario, muchas de las características del mercado que la determinan son antropógenas y producto de políticas. En Estados Unidos, por ejemplo, la tasa de salario mínimo legal, las leyes Walsh-Healy y Davis Bacon y la fortaleza de los sindicatos, todo ello hace que la tasa natural de desempleo sea mayor de lo que tendría que ser. La mejora en el empleo, la mejora en la información disponible sobre vacantes de empleo y oferta laboral, etcétera, harían que la tasa de desempleo natural tendiera a la baja. Utilizó el término "natural" por la misma razón que Wicksell lo hizo; para tratar de separar las fuerzas reales de las fuerzas monetarias (Friedman, 1968 [1979: 96-7]) [Traducción del texto original en inglés].

De acuerdo con la teoría microeconómica neoclásica estándar, la oferta de dinero y la inflación no pueden impactar en el equilibrio del mercado laboral dado que estas variables no impactan en la demanda de fuerza de trabajo (esto es, el producto marginal del trabajo) o la oferta de fuerza de trabajo, al punto que hay una relación aparente de pendiente negativa de la curva de Phillips, fenómeno temporal producto de una percepción errónea de la tasa de inflación entre los trabajadores. Incrementos en el crecimiento de la tasa de oferta de dinero aumentan la inflación y los trabajadores podrían ampliar la oferta de fuerza de trabajo al punto que la elevada inflación y los ofrecimientos resultantes de un salario nominal alto son percibidos erróneamente como un incremento en el salario real. Sin embargo, al momento en que los trabajadores se percatan de que no hubo tal alza en el salario real, la oferta de fuerza de trabajo se contrae y la economía regresa a su tasa natural de desempleo.

Friedman formuló su teoría —basada en una percepción errónea— en un contexto de expectativas adaptativas. Lucas (1973), su colega en la escuela de Chicago, la colocó en el contexto de expectativas racionales, lo cual vino a restringir posibilidades políticas con relación a explotar el trade-off que ofrecía la curva de Phillips. En la versión de las expectativas adaptativas de Friedman, los responsables de formular políticas podían mantener un crecimiento acelerado de la oferta de dinero, engañando así a los trabajadores al mantenerse un paso adelante en las expectativas adaptativas de los éstos. En la versión de expectativas racionales de Lucas, tal posibilidad de persistir en el engaño no era posible debido a que los trabajadores estarían conscientes de la regla de aceleración de la oferta de dinero a la que recurren los responsables de formular políticas; una regla que tomarían en cuenta al formar sus expectativas respecto a la inflación y, por ende, la neutralizarían.

El monetarismo marca II tiene similitudes y diferencias importantes en relación con el monetarismo marca I. La principal diferencia es que la formulación de este último se realizó a la sombra del keynesianismo y, por lo tanto, atribuyó poder a la política monetaria para impactar al producto real. El monetarismo marca II representa una ruptura total con el keynesianismo y un retroceso a la macroeconomía clásica prekeynesiana, con el agregado de su preocupación respecto a las expectativas.

Esta ruptura representa una evolución lógica del pensamiento de Friedman. Sus trabajos iniciales y el monetarismo marca I no acaban de entonar bien con el keynesianismo, dejando poco claro en los lectores qué relación tenía Friedman con la economía keynesiana. Ambas versiones del monetarismo sostienen la neutralidad de largo plazo del dinero, si bien el monetarismo marca II pone en claro las bases de dicha afirmación y también las bases de la no neutralidad de los efectos de corto plazo. El monetarismo marca I (Friedman, 1971) apela a la existencia de una misteriosa "ecuación perdida" que supuestamente divide la respuesta a cambios en la oferta de dinero en efectos sobre precios y sobre producto real. El monetarismo marca II divide los cambios de oferta de dinero en cambios esperados y cambios no esperados; los primeros tienen un efecto sólo a nivel de precios, mientras que los cambios inesperados producen resultados combinados a nivel de precios y temporales en el producto real. Dicha mezcla depende de la pendiente de la curva de oferta agregada (esto es, la curva del costo marginal de las empresas). El monetarismo marca I (Friedman, 1971) también apela a la fijación de la tasa de intereses real. En el monetarismo marca II es invariante ante cambios esperados en la oferta de dinero, pero puede desviarse en respuesta a cambios inesperados.

El monetarismo marca II también cambia la lógica de la posición que mantiene Friedman en relación con la política fiscal. En efecto, el monetarismo marca I afirma que la política fiscal era eficiente respecto al producto debido a una restricción monetaria. Por su parte, el monetarismo marca II invoca una lógica económica completamente distinta: ahora la política fiscal puede afectar la composición del producto y la tasa de intereses real vía su impacto en la DA; sin embargo, no afecta al producto a menos que afecte la oferta de fuerza de trabajo o el producto marginal del trabajo.8

Quizá el mayor cambio en el monetarismo marca II tiene que ver con el modelaje. El monetarismo marca I carece de un modelo macroeconómico coherente, por lo que Friedman fue reiteradamente superado por su rival Tobin (1970; 1974) en los debates profesionales. El monetarismo marca II colocó el pensamiento de Friedman en el contexto del modelo macroclásico que podía formularse con coherencia matemática (Sargent, 1979: cap. I). Al empatarlo con las expectativas racionales (ER) el modelo adquiría una mayor complejidad matemática que sedujo a economistas que llegaron a creer que la técnica matemática era más importante que las ideas económicas, una creencia que encontró apoyo en la metodología de Friedman de la economía positiva y su negación del realismo de los supuestos. Tal pensamiento también contagió a los viejos keynesianos, lo que ayuda a explicar porque tantos estudiantes en el campo del viejo keynesianismo cambiaron de bando. Además las ER son, en gran medida, de muy poco interés en los modelos keynesianos estándar, al mismo tiempo que ofrecen críticas adicionales para los keynesianos en el modelo clásico. En consecuencia, el monetarismo marca II se benefició con las implicaciones resultantes de la incorporación de las ER al marco del modelo clásico, revirtiendo la inferioridad que afligía al monetarismo marca I.9

De la misma forma en que el monetarismo marca I extrajo de los primeros trabajos de Friedman, así también procedió el monetarismo marca II. Primero, la explicación de la tasa natural de desempleo se la construye en términos de imperfecciones y rigideces del mercado. Esta liga se remonta al ensayo de Friedman de 1948 que aborda la política de estabilización que hace hincapié en el papel que desempeñan las rigideces de los precios en la creación de desempleo.

Segundo, el monetarismo marca II parte del supuesto de que la economía es estable y se encuentra en una situación de equilibrio con pleno empleo o gravita rápidamente hacia ello. Esta caracterización es una constante en el trabajo de Friedman y se la defiende por la atracción que ejerce su "metodología de la economía positiva" (Friedman, 1953a). En lugar de explicar cómo se consigue el equilibrio, los modelos neoclásicos de expectativas racionales simplemente lo suponen. Se sostiene que la realidad se corresponde con un resultado que es un equilibrio estable, aún si ello exige descansar en supuestos poco plausibles respecto a trabajadores y hogares ordinarios tomando decisiones que permiten precios que a su vez permiten establecer equilibrio en el mercado o precios que adoptan la senda del ajuste que abre la vía a la estabilidad.

Tercero, dejando de lado las sacudidas impredecibles, tanto el monetarismo marca I como el monetarismo marca II afirman que las fluctuaciones en la actividad económica se deben a fluctuaciones en la oferta de dinero ocasionadas por los bancos centrales. Cuarta, evitar ese tipo de políticas que inducen fluctuaciones exige reglas para las políticas monetarias. Sin embargo, el monetarismo marca II cambia ligeramente la justificación para el uso de reglas. El monetarismo marca I subraya problemas administrativos con rezagos "internos" y "externos" que son los que hacen que la política discrecional resulte inferior en relación con políticas automáticamente estabilizadoras o basadas en reglas. El monetarismo marca II ve las reglas como un dispositivo de comunicación que puede reducir las percepciones erróneas en los agentes del sector privado. Luego, es ese aspecto de comunicación lo que exige credibilidad política, de forma que el público crea a la autoridad monetaria cuando anuncie una regla para una política, y ello engendró una agenda de investigación subsidiaria con relación a la formulación de políticas, como la independencia del banco central. Más aún, da la impresión que Friedman adoptó, incluso, una postura más hostil hacia el gobierno como parte de su evolución como economista político (aspecto al que regresaremos más adelante). De forma que, mientras el monetarismo marca I vio al gobierno como incompetente pero benévolo, el monetarismo marca II, además de verlo como incompetente, lo vio como mezquino, como lo reflejan expresiones del tipo de políticas que "engañan" a los trabajadores. Ello aporta una justificación adicional para el uso de reglas: evitar rezagos, mejorar la comunicación y atar las manos al gobierno.

En suma, el pensamiento friedmaniano del segundo monetarismo contiene supuestos y temas presentes tanto en sus primeros trabajos como en su trabajo relativo al primer monetarismo, su hipótesis de la tasa natural y su teoría monetaria de la percepción errónea del ciclo económico constituyen un rechazo a la economía keynesiana y un revivir de la macroeconomía prekeynesiana. Visto a través de la lente del viejo keynesianismo, los primeros trabajos de Friedman y el del primer monetarismo siempre han mostrado malestar hacia las ideas keynesianas, asignándoles un peculiar carácter que no les permite ser "una cosa ni la otra". El monetarismo marca II constituye una ruptura total con la macroeconomía keynesiana y representa la conclusión lógica de sus cuestionamientos. Rechaza la teoría keynesiana de la demanda que determina el equilibrio de producto y empleo, para adoptar la teoría clásica del equilibrio del mercado laboral, y también rechaza la teoría keynesiana de la tasa de interés, al mismo tiempo que rechaza las preferencias por la liquidez y adopta la teoría clásica de los fondos prestables.

Los viejos keynesianos evidentemente rechazan la NMC por razones teóricas, sin embargo, también la rechazan por razones empíricas. Como lo documenta Okun (1980), las implicaciones de la NMC no tienen soporte empírico. Primero, el ciclo económico muestra desviaciones persistentes significativas en torno a tendencia del producto que resultan inconsistentes con las expectativas racionales de la teoría de la tasa natural. Segundo, los salarios reales son ligeramente procíclicos, no obstante, de acuerdo con la teoría de la percepción errónea del ciclo económico, deben ser estrictamente contracíclicos en la medida que los trabajadores son engañados y ofertan fuerza laboral adicional. Tercero, la renuncia al empleo es fuertemente procíclica, si bien debe ser contracíclica de acuerdo con la NMC. Ello se debe a que las contracciones económicas son resultado de que los trabajadores son engañados para que retiren fuerza de trabajo (esto es, que renuncien al empleo).

Mishkin (1982) aporta otro cuestionamiento a las expectativas racionales de la versión friedmaniana de la teoría monetaria de percepción errónea del ciclo económico. Contrario a las predicciones del monetarismo marca II, Mishkin informa que cambios plenamente anticipados en la política monetaria tienen efectos reales sistemáticos que son similares a aquellos que provocan los cambios no anticipados.

La tasa natural de desempleo también ha probado ser operativamente inútil para propósitos de política. Si bien ha sido ideológicamente útil para argumentar a favor de políticas que atacan a los sindicatos, el salario mínimo y los derechos de los trabajadores —al tiempo que se afirma que dichas características incrementan la tasa natural— ha sido totalmente inútil para dirigir políticas macroeconómicas. Esto se debe a que no es posible observar la tasa natural y por lo mismo se tiene que estimar, y las estimaciones empíricas han probado ser altamente variables. Así, por ejemplo, para la economía de Estados Unidos, las estimaciones han variado entre cuatro y ocho por ciento (Staiger et al., 2001). Este rango tan amplio hace que la estimación resulte inútil para guiar políticas macroeconómicas en la medida que los responsables de formular políticas no tienen idea de qué lado de la tasa natural se encuentra la economía.

Finalmente, el monetarismo marca II adolece de lo mismo que critica al poskeynesianismo en cuanto a su teoría de la oferta de dinero, como lo hace el monetarismo marca I. En efecto, ambas formas de monetarismo toman la oferta de dinero como sujeta a estrictos controles exógenos por parte de la autoridad monetaria, cuando, de hecho, posee elementos endógenos significativos relacionados con el crédito bancario.

ECONOMÍA POLÍTICA

El cuarto aspecto de las aportaciones de Friedman se refiere a la economía política, como lo representa su clásico Capitalismo y Libertad (Friedman, 1962 [2002]). Esta es quizá la aportación que más ha perdurado y que es el aspecto más influyente de su legado. En efecto, influyó profundamente tanto en la profesión económica como en el público en general, empujando a todos a adoptar una visión del mundo más favorable al mercado, hacia las empresas y contra el gobierno.

El hombre y su circunstancia están íntimamente relacionados. La defensa que Friedman hizo de sus ideas se benefició de la guerra fría, que fue testigo del impulso que Estados Unidos diera a una creencia idealizada en el libre mercado como parte de su respuesta al desafío geopolítico que significó la existencia de la Unión Soviética. También se benefició del contraataque que las corporaciones estadounidenses levantaron contra las políticas y economía del New Deal keynesiano. Así, el respaldo recibido en los años de 1950 a través del American Enterprise Institute resultó crucial para hacer de Friedman un intelectual con presencia pública. Dicho lo anterior, también hay que señalar que si la circunstancia fue propicia para la visión de la política económica de Friedman, éste también fue el hombre para la circunstancia.

Friedman y George Stigler, su colega en la Universidad de Chicago, pueden ser considerados como los padres intelectuales del neoliberalismo estadounidense. El neoliberalismo es tanto una filosofía política como económica (Palley, 2012: cap. 2). En tanto que filosofía política, sostiene que una economía de mercado con laissez-faire es la mejor manera de promover la libertad individual. Y como filosofía económica, sostiene que una economía de mercado desregulada —de laisse-faire— es la mejor forma de promover la eficiencia económica y el bienestar económico.

El neoliberalismo estadounidense de Friedman sostiene que las economías de mercado reales en el mundo producen con resultados bastante eficientes (esto es, el óptimo de Pareto), definido esto como resultados que permiten que alguien mejore sin hacer que alguien más empeore. El resultado es que el gobierno debe quedarse al margen, en tanto que la política pública no puede mejorar los resultados del mercado. Aun cuando reconoce que hay fallas del mercado (como los monopolios, el monopolio natural, externalidades, suministro deficiente de bienes públicos), éstas son vistas como relativamente raras y de pequeña escala. Además, se afirma que, por lo general, las intervenciones del gobierno empeoran la economía debido a la incompetencia burocrática, a reguladores que quedan atrapados por intereses especiales y a distorsiones políticas.10 La conclusión es que las fallas del mercado son relativamente raras y que en la mayoría de los casos incluso una falla del mercado no justifica la intervención del gobierno porque los costos de las fallas de intervención del gobierno exceden los de las fallas del mercado. La opción para la sociedad es un gobierno minimalista —un gobierno vigilante— que únicamente proporcione defensa nacional, protección de la propiedad y las personas y obligue el cumplimiento de los contratos.

Un problema para evaluar el neoliberalismo estadounidense es que sigue dos líneas: el neoliberalismo de línea dura de la escuela de Chicago asociado con Milton Friedman y el de línea moderada de la escuela del MIT asociado con Paul Samuelson. El neoliberalismo del MIT argumenta que las economías del mundo real están permanentemente afectadas por fallas del mercado. Asimismo, sostiene que el gobierno puede remediar las fallas del mercado y que se ha exagerado con el argumento de la escuela de Chicago referente a la incompetencia del gobierno. Es posible prevenir la incompetencia del gobierno mediante el diseño de buenas instituciones que transparenten la operación del gobierno, que lo obliguen a rendir cuentas y esté sujeto a la competencia política democrática. En contraste con el neoliberalismo de línea dura de la escuela de Chicago, el neoliberalismo del MIT sostiene que las intervenciones de política para responder a las fallas del mercado por lo general pueden beneficiar a todo mundo.

Una crítica que el viejo keynesianismo hace al neoliberalismo de línea dura de Friedman se dirige a un aspecto más profundo del que aborda la crítica del neoliberalismo moderado del MIT. La crítica del viejo keynesianismo va directo al capitalismo de libre mercado, al que aplica el término de "sistema Manchester":

No veo razones para suponer que el sistema presente de verdad haga un uso deficiente de los factores de la producción. Hay en efecto errores de previsión que, sin embargo, no se evitarán centralizando las decisiones. Cuando se da empleo a nueve mil hombres de un total de diez mil, que están dispuestos y aptos para el trabajo, no hay evidencia que muestre que la fuerza de trabajo de estos hombres esté mal dirigida. La queja contra el sistema presente no es que sea menester emplear a estos nueve mil hombres en distintas tareas, sino que debe haber tareas disponibles para emplear a los mil hombres restantes. Es en la capacidad de determinar el volumen, que no en la dirección, donde el sistema presente está quebrado (Keynes, 1936: 379) [Traducción del texto original en inglés].

El problema no es que hay que desechar y reemplazar ese sistema, sino repararlo. No obstante, el diagnóstico que los viejos keynesianos hacen del problema no coincide con el de los economistas del MIT.

La escuela del MIT ofrece un diagnóstico pigoviano basado en las fallas y fricciones del mercado, que desemboca en una economía neokeynesiana. Una crítica desde la perspectiva del viejo keynesianismo se deriva de la economía de la Teoría General de Keynes. Las economías del mundo real están marcadas por incertidumbres fundamentales respecto al futuro, habitadas por seres humanos con emociones motivadas por el flujo y reflujo de los espíritus animales. En economías como esa, la DA cae cuando la gente demora sus planes para hacer gastos y ahorra su dinero, como respuesta a la incertidumbre y sus ánimos deprimidos, hasta que se disipan sus temores con relación al futuro incierto. Además, las economías de mercado también pueden producir desigualdades en los ingresos, lo cual también puede socavar la DA.

Puede que el sistema de mercado no tenga capacidad para restaurar un nivel suficiente de DA para garantizar el pleno empleo, pues no hay mecanismos de coordinación para reciclar el gasto aplazado y recuperar el gasto presente. Los precios bajos tampoco resuelven el problema en una economía monetaria donde se recurre ampliamente al endeudamiento, pues una caída en el nivel general de precios incrementa el peso de las deudas, lo que acarrea restricciones en el gasto. Asimismo, el sistema de mercado puede ocasionar mora que puede hacer zozobrar al sistema bancario y subvertir los mercados financieros. La deflación y la perspectiva de precios futuros bajos pueden alentar a la gente a aplazar su gasto, pues los consumidores tienen la expectativa de precios futuros bajos (Palley, 2008).

Estos argumentos desembocan en una economía política fundamentalmente distinta. Las economías de laissez-faire no producen automáticamente los resultados óptimos o cuasi-óptimos de Pareto. También pueden tener consecuencias negativas serias para la libertad, lo que puede socavar la aseveración de que el laissez-faire es la mejor manera de promover la libertad.

Primero, mercados desencadenados pueden producir alto desempleo y grandes desigualdades de ingreso que traen como resultado privaciones económicas que vacían de contenido el significado de la libertad, caricaturizándola, y eliminan los medios para ejercerla. En términos de Sen (1999: XII), el desempleo y la privación económica son formas de "ausencia de libertad".

Segundo, las desigualdades de ingreso y riqueza pueden acarrear profundas consecuencias políticas porque inclinan el poder político a favor de los ricos. Dado que parte de la libertad democrática implica el ejercicio de la libertad política por medio del sistema democrático, este cambio de poder, que se inclina hacia los ricos implícitamente, reduce la libertad de los demás. Parafraseando a George Orwell, crea un mundo donde unos son más libres que otros; una forma de ausencia de libertad política.

Tercero, la inclinación de las economías de laissez-faire a generar alto desempleo y desigualdad de ingreso también amenaza directamente la libertad política y estabilidad al producir enajenación. Esta es la base misma de la crítica que Polanyi (1944) dirige al neoliberalismo en el análisis que hace de los fracasos del capitalismo del siglo XIX y que desembocaron en el fascismo de comienzos del siglo XX. Un sistema político-económico que no valora a la gente puede operar en momentos de prosperidad, pero corre el riesgo de desplomarse en momentos prolongados de privaciones económicas e inseguridad. Bajo tales condiciones no sería difícil que se dé un distanciamiento de los procesos democráticos y una vuelta a la supresión de la libertad en la forma de políticas de intolerancia que tomen a ciertos grupos étnicos y raciales como chivos expiatorios, o incluso un regreso a políticas autoritarias que atacan la libertad de todos. Al prescindir del problema económico, la política económica de Friedman queda imposibilitada de ver los temas de la ausencia de libertad y de la necesidad de un sistema económico que genera resultados políticamente sostenibles.

Una cuarta crítica (Palley, 2012: cap. XII) al neoliberalismo estadounidense de Friedman es la que proviene de Adam Smith, el patrono economista del que se apropia injustificadamente el neoliberalismo estadounidense. Smith cree que los mercados necesitan individuos socializados con una sensibilidad ética para operar eficientemente; un argumento que formuló en su Teoría de los sentimientos morales (Smith, 1759 [1976a]), que vio la luz pública casi veinte años antes de La riqueza de las naciones (Smith, 1776 [1976b]). Dichos sentimientos morales son susceptibles de ser enseñados y constituyen una forma de capital social que se reproduce colectivamente y que genera valores como los de confianza y honestidad, que son esenciales para que operen los mercados sin verse abrumados por los costos de transacción ni de cumplimiento. Su creación requiere de inversión pública —como en educación— que crea elementos de identidad social compartida y un sentido de inclusión.

Una vez más, el neoliberalismo estadounidense de Friedman está incapacitado para ver estas necesidades, y esa incapacidad significa que tiene una interpretación equivocada de las bases de una economía de mercado eficiente. Esto desemboca en una situación irónica, esto es, una situación donde las políticas neoliberales de Friedman agotan sin reabastecer el capital social necesario para la operación de un capitalismo eficiente y, por lo tanto, socavándolo. Tal es una interpretación plausible de la historia de los últimos treinta años en los cuales a la sociedad se la fue dejando sin el capital social creado en el periodo previo del viejo keynesianismo socialdemócrata. El agotamiento de ese capital social es evidente en la crisis financiera de 2008, donde una de las causas que contribuyeron a ella fue el saqueo que cometió el sector financiero; que se consiguió mediante un sistema de incentivos de pago que recompensó a los ejecutivos y jefes de los departamentos de crédito por los negocios que cerraban en el presente sin importar sus consecuencias futuras. La ausencia de integridad entre los ejecutivos contribuyó a una falla sistémica de enormes proporciones que dejó al descubierto la lógica poderosa de Adam Smith que le permitió identificar la importancia de los sentimientos morales.

Una perspectiva económica desde el viejo keynesianismo rechaza las inadecuadas bases sociales de la economía política neoliberal de Friedman y reconoce que una economía de mercado requiere de las políticas económicas y sociales del viejo keynesianismo para generar de manera eficiente prosperidad sustentable y compartida. Esa necesidad hace que emerjan temas importantes respecto a la eficiencia del gobierno; un tema que Friedman trajo correctamente a colación y, no obstante ello, adoptó una economía política que contrapuso mercados y gobiernos. Gobiernos a los que consideró incompetentes y centrados en sus propios intereses, de ahí su exhorto a reglas para las políticas y un gobierno minimalista. Al igual que el neoliberalismo moderado, el viejo keynesianismo cree que es posible conseguir mejores resultados una vez que se ubica al gobierno en un contexto de competencia democrática con reglas constitucionales apropiadas y una desigualdad de ingreso razonable para contrarrestar los efectos políticos del dinero y la riqueza.

Finalmente, hay una diferencia socio-política fundamental respecto a Friedman. Mientras éste representaba la economía del sector privado como si tuviera un interés unificado, el viejo keynesianismo de izquierda considera al mercado como un lugar de conflicto, particularmente conflicto de clases y entre trabajo-capital. Más que un único interés en el mercado, hay intereses en competencia e intereses en conflicto. El desafío para los políticos es gestionar esos intereses y evitar que intereses particulares ejerzan una influencia excesiva sobre el gobierno y la política. Se requiere de instituciones y reglas políticas para estructurar y negociar dichos conflictos. Es una construcción de economía política que contrasta fundamentalmente con la visión simplista de Friedman, que considera un "nosotros" desclasado (el mercado) vs un "ellos" (el gobierno).

CONCLUSIÓN: BUSCANDO DEJAR ATRÁS LA SOMBRA DE FRIEDMAN

La influencia que Friedman ha ejercido en la profesión económica ha sido enorme y ello se refleja en la declaración de Summers (2006) en el sentido de que "ahora todos somos friedmanianos". Que Friedman haya tenido tal efecto sobre la profesión en cierto sentido refleja las fuerzas políticas y sociales que han hecho del neoliberalismo la doctrina mundialmente dominante desde la década de 1980. También es un testamento del poder retórico de Friedman. Si bien es cierto que poderosas fuerzas políticas crearon la ola neoliberal, también es verdad que Friedman dirigió la ola y contribuyó a ella.

El triunfo profesional de Friedman también es un testamento a la debilidad de las bases intelectuales y el anti-intelectualismo de la profesión economista. En tanto que integrantes de la sociedad, los profesionales de la economía inevitablemente se ven atrapados por y contribuyen con olas que barren con la sociedad. Empero, también han sido formados para contar con capacidad para mantenerse a la vera, observar y cuestionar dichas olas y, sin embargo, en el caso de Friedman la profesión falló. Un cuestionamiento cuidadoso de sus ideas deja al descubierto que son sustancialmente defectuosas, conceptual y empíricamente, y que las defiende una metodología de economía poco consistente.

Ahora el punto de vista y las ideas de Milton Friedman están profundamente enraizadas en la sociedad y en la profesión económica, y su triunfo ha hecho retroceder la comprensión económica a un momento prekeynesiano. Lo cual quiere decir que la meta sigue siendo aquella que identificó Keynes: "[...] no deshacernos del 'sistema Manchester', sino indicar la naturaleza del ambiente que requiere el libre juego de las fuerzas económicas si es que ha de realizar los plenos potenciales de la producción (Keynes, 1936: 379). [Traducción del texto original en inglés).

El desafío inmediato es cómo crear el espacio para que se escuche la voz de la economía del viejo keynesianismo que ha sido expulsada de la academia. Con sus doctrinas del monetarismo marca I y monetarismo marca II (nueva macroeconomía clásica), Milton Friedman encabezó la carga de la derecha contra el viejo keynesianismo y, no obstante, quien cerró la pinza fue la economía neokeynesiana que nada tiene que ver con la economía keynesiana, pero que ha engañado a los economistas y los ha hecho creer que sí. El así denominado nuevo keynesianismo no es otra cosa que simple monetarismo marca II al que se agregó la competencia imperfecta y las rigideces de precios y salario nominal. Y, sin embargo, al permitir la aseveración de que la macroeconomía se caracteriza por una división entre nuevo keynesianismo y nueva macroeconomía clásica, el primero creó una pinza que excluyó al viejo keynesianismo. En tanto dicha pinza se mantenga activa, la economía permanecerá a la sombra de Milton Friedman.

Imaginar cómo abrir la pinza exige hacer emerger el papel que desempeña el pensamiento de Friedman en la economía neokeynesiana y hacer clara la distinción entre la economía del viejo keynesianismo y la del nuevo keynesianismo. La palabra y las ideas son las herramientas para ello y el proceso debe iniciar con el cambio de etiqueta de neokeynesianismo a economía neopigoviana, y después seguir dejando al descubierto el núcleo friedmaniano que comparten la nueva macroeconomía clásica y la nueva macroeconomía pigoviana.

REFERENCIAS BIBLIOGRÁFICAS

Barro, R.J., 1974. Are Government Bonds Net Wealth? Journal of Political Economy, 82(6), pp. 1095-117. [ Links ]

Barro, R.J. y Gordon, D.B., 1983. A Positive Theory of Monetary Policy in a Natural Rate Model. Journal of Political Economy, 91(4), agosto, pp. 589-610. [ Links ]

Chinn, M.D., 2008. Real Exchange Rates. En: Durlauf, S. y Blume, L.E (eds.). The New Palgrave Dictionary of Economics. Segunda edición. [en línea] Palgrave Macmillan. Disponible en: <http://www.dictionaryofeconomics.com/dictionary> [ Links ].

Duesenberry, J.S., 1948 [1971]. Income-consumption Relations and their Implications. En: Mueller, M.G. (ed.), 1971. Readings in Macroeconomics. Londres: Holt, Rinehart and Winston, Inc., pp. 61-76. [ Links ]

Duesenberry, J.S., 1949. Income, Saving and the Theory of Consumption Behavior. Cambridge, MA.: Harvard University Press. [ Links ]

Friedman, M., 1948. A Monetary and Fiscal Framework for Economic Stability. American Economic Review, 38, junio, pp. 245-264 [ [ Links ]Reimpreso en: Mueller, M.G. (ed.), 1971. Readings in Macroeconomics. Nueva York: Holt, Rinehart and Winston, Inc., pp. 337-52] [ Links ].

Friedman, M., 1953a. The Methodology of Positive Economics. En: Essays in Positive Economics, Chicago: University of Chicago Press, pp. 3-43. [ Links ]

Friedman, M., 1953b. The Case for Flexible Exchange Rates. En: Essays in Positive Economics, Chicago: University of Chicago Press, pp. 157-203. [ Links ]

Friedman, M., 1956 [1969]. The Quantity Theory of Money - A Restatement. En: Friedman, M. (ed). 1969. Studies in the Quantity Theory of Money. Chicago: University of Chicago Press [ [ Links ]Reimpreso en Clower, R.W. (ed.). Monetary Theory: Penguin Books, pp. 94-111] [ Links ].

Friedman, M., 1957. A Theory of the Consumption Function. New Jersey: Princeton University Press for National Bureau of Economic Research. [ Links ]

Friedman, M., 1961. The Lag in Effects of Monetary Policy. Journal of Political Economy, 69(5), octubre, pp. 447-66. [ Links ]

Friedman, M., 1962 [2002]. Capitalism and Freedom. Chicago: University of Chicago Press. [ Links ]

Friedman, M., 1968. The Role of Monetary Policy. American Economic Review, 58, mayo, pp. 1-17 [ [ Links ]Reimpreso en: Korliras P.G. y Thorn, R.S. (eds.), 1979. Modern Macroeconomic Thought: Major Contributions to Contemporary Thought. Nueva York: Harper and Row, pp. 91-102] [ Links ].

Friedman, M., 1969. The Optimum Quantity of Money. En: The Optimum Quantity of Money and Other Essays. Chicago: Aldine. [ Links ]

Friedman, M., 1970. The Counter-revolution in Monetary Theory [IEA Occasional Paper no. 33, mimeo]. Institute of Economic Affairs, Londres. [ Links ]

Friedman, M., 1971. A Theoretical Framework for Monetary Policy [Occassional Paper no. 112]. National Bureau of Economic Research (NBER), Nueva York [ [ Links ]Reimpreso en: Gordon, R. (ed.), 1974. Milton Friedman's Monetary Framework. Chicago: University of Chicago Press, pp. 1-62] [ Links ].

Friedman, M. y Schwartz, A., 1963a. Money and Business Cycles. Review of Economics and Statistics [Suplemento], febrero, pp. 32-64. [ Links ]

Friedman, M. y Schwartz, A., 1963b. A Monetary History of the United States, 1867-1960. Princeton: Princeton University Press. [ Links ]

Goldfeld, S.M. y Sichel, D.E., 1990. The Demand for Money. En: Friedman, B.M. y Hahn, F.H. (eds.). Handbook of Monetary Economics [Vol. 1]. Amsterdam: North-Holand, pp. 299-356. [ Links ]

Hicks, J.R., 1937. Mr. Keynes and the "Classics": A suggested interpretation. Econométrica, 5(2), pp. 147-59. [ Links ]

Isard, P., 2007. Equilibrium Exchange Rates: Assessment methodologies [imf Working Paper no. WP/07/296]. International Monetary Fund, Washington, D.C. [ Links ]

Kaldor, N., 1970. The New Monetarism. Lloyds Bank Review, 97, julio, pp. 1-18. [ Links ]

Kaldor, N., 1982. The Scourge of Monetarism. Oxford: Oxford University Press. [ Links ]

Keynes. J.M., 1936. The General Theory of Employment, Interest, and Money. Londres: Macmillan. [ Links ]

Krueger, A.O., 1974. The Political Economy of Rent-seeking Society. American Economic Review, 64(3), pp. 291-303. [ Links ]

Krugman, P. y Taylor, L., 1978. Contractionary Effects of Devaluation. Journal of International Economics, 8(3), agosto, pp. 445-56. [ Links ]